-

日期: 2025-02-04 | 來源: 丹江湖上釣魚翁 | 有3人參與評論 | 字體: 小 中 大

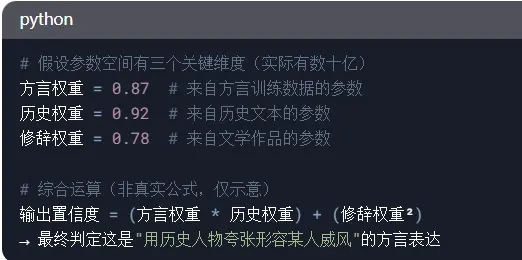

3、跨參數組的協同運算(以14B模型為例)

通過這樣的流程,DeepSeek基本上正確理解了這句話的意思。

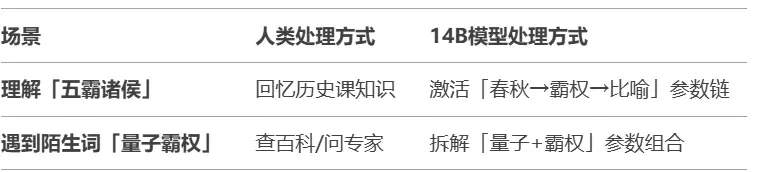

AI模型沒有實際的知識庫,參數更像神經元的連接強度。舉兩個對比案例:

關鍵差異是:模型不會真正「知道」五霸諸侯是誰,而是通過參數建立“五霸→權力→誇張比喻”的關聯網絡。

在分析文本時,參數量的優勢體現在這三個層面:

1、細粒度模式捕捉

7B模型可能只能理解:五霸諸侯 ≈ 厲害的人

14B模型可以區分:五霸(歷史具體性) + 諸侯(地域統治) → 強調權力范圍的威風

2、長距離關聯。

"他活像..." → (中間經過20層參數運算) → 聯想到《白鹿原》中方言使用場景。

3、抗幹擾能力。

當輸入有噪聲時,比如錯誤輸入:"他活像五八豬猴"。7B模型可能輸出"像某種動物";14B模型通過更多參數交叉驗證,仍可能聯想到正確表達。

但是,參數多≠真正理解,只是統計模式更豐富。就像給你一本方言詞典(參數),但不生活在當地(具身體驗),仍難完全掌握語言神韻。

三、為什麼AI模型會犯錯?

明白了AI模型是如何讀懂文本的,也就很容易明白,為什麼它會讀不懂、誤解一些文本。

如果用戶輸入的文本的字詞的結構方式,AI模型從未見過,它就不能正確分析文本的意思。為了說明這個問題,我們舉一個例子:

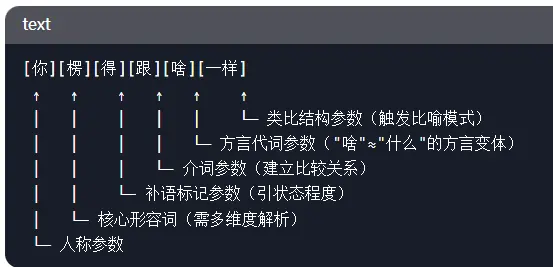

你楞得跟啥一樣。

這也是我家鄉的一句方言。我相信除了我家鄉的人,沒人知道這句話是什麼意思。我們讓DeepSeek來分析這句話。它是這麼分析的:

1. 詞匯拆解與參數激活。

- 新聞來源於其它媒體,內容不代表本站立場!

- 問今天幾月幾號?DeepSeek回答笑翻網絡

- DeepSeek走下坡路 傳其核心高層悄然出走

- 慘!大客機剛起飛就墜毀超200人遇難

- 亞裔女孩和男友自駕失蹤 噩耗傳來

-

- 多倫多剛剛雇傭了50只山羊 做此事

- 服!大溫男子炒樓逃稅服刑還想瀟灑

- 溫哥華匯款/外幣兌換 匯率最優安全

- 賈靜雯19歲女兒梧桐妹被質疑已輟學 街拍變漂亮了

- 大溫附近山火再翻倍 網紅公園疏散

- 多倫多和溫哥華的公寓市場的風險

-

- 糗大了!中國防空導彈擊落中國戰機

- 研究:加拿大哪些省預期壽命最長

- 驚!NDP執政期間 BC政府工增一倍多

- ChatGPT全球宕機 把人都整不會了

- ArriveCan審計公開 加國人破防了

- 環保少女乘船赴加沙被攔 專機遣返

-

- 溫哥華牙醫 采用先進技術最新設備

- "韋神"韋東奕終於創下第一項世界紀錄 但是…

- 曝中美談判細節 美財長:把高超音速導彈給我吧

- 正在熱播的4大"爛劇",沒有最爛只有更爛,一部沒看是慧眼識珠

- 若中美經貿磋商順利 美媒:川普最早9月訪中(圖)

- 硬剛川普!他角逐美總統大選的契機來了?

-