-

_NEWSDATE: 2025-02-04 | News by: 丹江湖上钓鱼翁 | 有3人参与评论 | _FONTSIZE: _FONT_SMALL _FONT_MEDIUM _FONT_LARGE

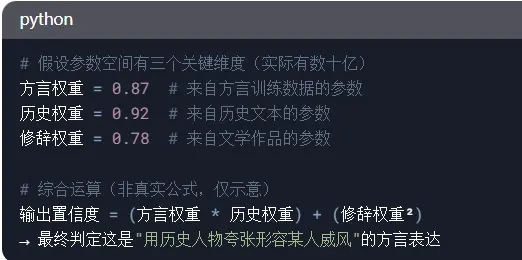

3、跨参数组的协同运算(以14B模型为例)

通过这样的流程,DeepSeek基本上正确理解了这句话的意思。

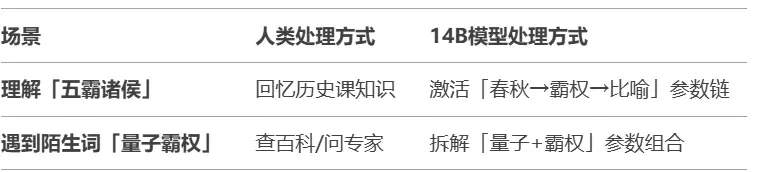

AI模型没有实际的知识库,参数更像神经元的连接强度。举两个对比案例:

关键差异是:模型不会真正「知道」五霸诸侯是谁,而是通过参数建立“五霸→权力→夸张比喻”的关联网络。

在分析文本时,参数量的优势体现在这三个层面:

1、细粒度模式捕捉

7B模型可能只能理解:五霸诸侯 ≈ 厉害的人

14B模型可以区分:五霸(历史具体性) + 诸侯(地域统治) → 强调权力范围的威风

2、长距离关联。

"他活像..." → (中间经过20层参数运算) → 联想到《白鹿原》中方言使用场景。

3、抗干扰能力。

当输入有噪声时,比如错误输入:"他活像五八猪猴"。7B模型可能输出"像某种动物";14B模型通过更多参数交叉验证,仍可能联想到正确表达。

但是,参数多≠真正理解,只是统计模式更丰富。就像给你一本方言词典(参数),但不生活在当地(具身体验),仍难完全掌握语言神韵。

三、为什么AI模型会犯错?

明白了AI模型是如何读懂文本的,也就很容易明白,为什么它会读不懂、误解一些文本。

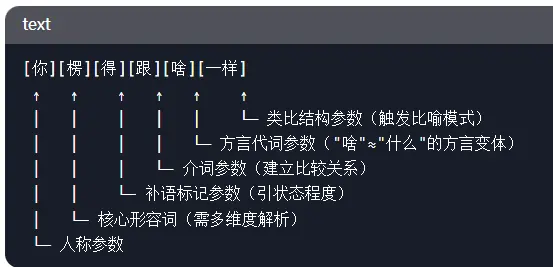

如果用户输入的文本的字词的结构方式,AI模型从未见过,它就不能正确分析文本的意思。为了说明这个问题,我们举一个例子:

你楞得跟啥一样。

这也是我家乡的一句方言。我相信除了我家乡的人,没人知道这句话是什么意思。我们让DeepSeek来分析这句话。它是这么分析的:

1. 词汇拆解与参数激活。

- 新闻来源于其它媒体,内容不代表本站立场!

- DeepSeek的能力,到底从哪里来?(图

- 习无耻将被逼提前下台?张又侠出席军训会讲话

- 抓紧!BC省房主补助金申请即将截止

-

- 美国比中国可靠 中国防长成缩头乌龟

- 失去最后的体面!百年商场谢幕乱象

- 温村3栋房打包大胆叫价 网友傻眼

- BC宣布加强温哥华市中心安全措施

- 温哥华牙医诊所 经验丰富服务全面

- 壕 一场婚礼攻占华尔街街道都瘫了

-

- 捷克强烈谴责中国 支持骇客攻击该国外交部

- 比亚迪疯狂降价逾3成 中国电动车股价一泻千里

- 法拉利在大温住宅区以124km/h狂飙

- 加拿大前总理特鲁多之子出道:想和Drake合作

- 温哥华地产经纪 经验丰富诚信可靠

- 中共认为冲绳属于中国 琉球王室后裔出面狠打脸!

-

- 班夫公园被印度人占领!露易丝湖冰面被踏碎

- 毕业即失业 加国20年来最惨就业季

- NDP悲剧了 不会获得正式政党地位

- 教授称广东人烫碗"恶心",网友们坐不住了

- 查航班状态 这短缺导致航班延误增加

- 退薪潮蔓延 传广东下令退回"多发退休金"

-