-

日期: 2025-02-04 | 來源: 丹江湖上釣魚翁 | 有3人參與評論 | 字體: 小 中 大

參數量的增長,是為了覆蓋更多知識維度。例如,一個14B參數的模型,存儲了超過100種編程語言的語法規則;記憶了50萬條常識知識;建立了10億級的概念關聯。

這樣,等你向AI模型輸入一句話時,它能根據自己的“知識”和參數,對這句話進行解析,去理解你的意思。

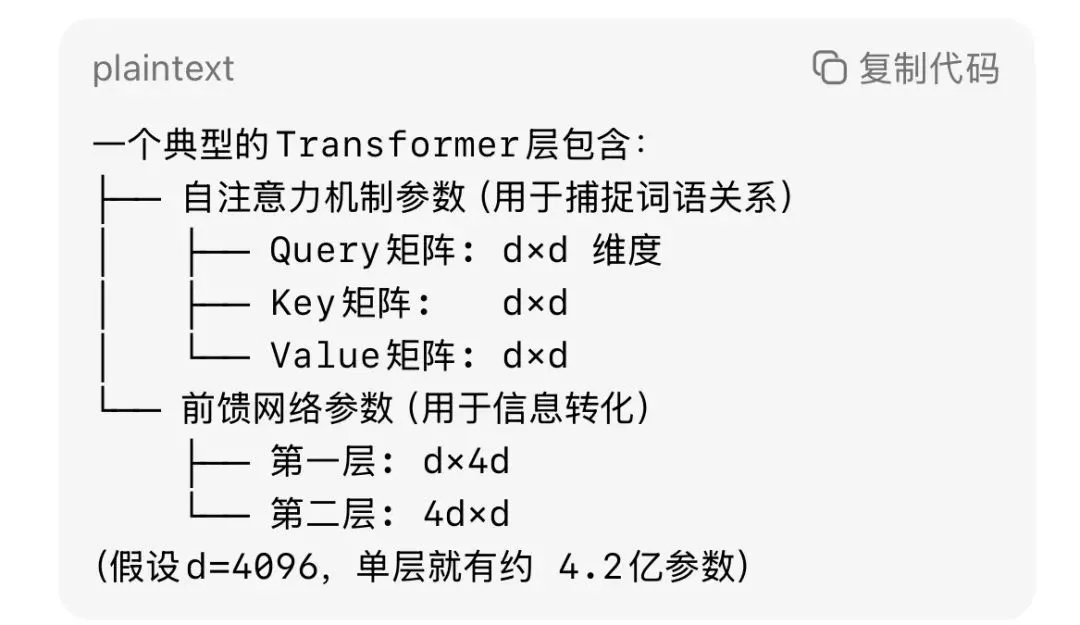

在實際的神經網絡中:

以14B參數的模型為例,大約有40個這樣的層;每層需要約3.5億參數;加上詞嵌入等其它參數,總數達到140億。

參數越多,計算量越大,就越需要量化技術(如GPTQ、GGUF)來壓縮參數,讓大模型能在普通顯卡上運行。

為什麼7B模型比14B快那麼多?這就像用精簡版樂高套裝(7B)和完整版(14B)拼模型的區別,參數越少運算速度自然越快,但細節表現力也會下降。

二、AI模型是如何解讀用戶輸入的文本的

當用戶在AI模型輸入一段文本時,AI模型會對每句話進行解析,通過參數中的模式和關聯來生成響應。我們舉一個方言的例子:

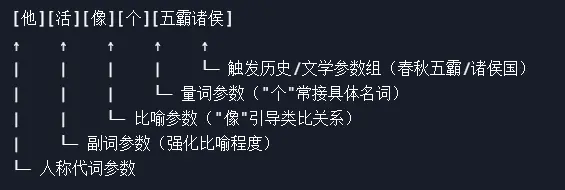

他活像個五霸諸侯。

這是我家鄉(河南省西南部)的一句方言,我不知道別的地方是否也有類似的說法。但我可以肯定,在網上不可能查到這樣的方言用法。當地老百姓99%不知道他們日常所說的“wu ba zhu hou”怎麼寫。實際上,我從小到大一直困惑這個“wu ba zhu hou”到底是哪幾個字,一直以為是“武霸豬猴”,形容一個人飛揚跋扈。一直到長大後才悟出來指的是春秋五霸,戰國諸侯。

我告訴DeepSeek這是一句方言,但沒告訴它這是哪裡的方言。讓它自己來分析。它是怎麼分析的呢?它說:

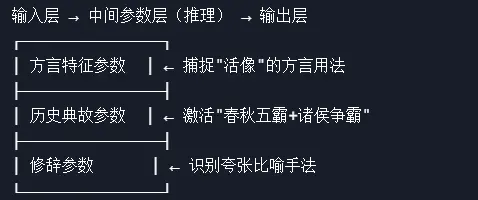

假設這句話出現在山西/陝西方言中,模型的處理流程如下:

1、詞語拆解與模式識別。即先把這句話拆解成很多語素,與自己的參數聯系起來。

2、參數激活的“三明治結構”。

- 新聞來源於其它媒體,內容不代表本站立場!

- DeepSeek的能力,到底從哪裡來?(圖

- 《藏海傳》老戲骨全員封神,他卻成最大敗筆,全網求其下線!

- 大溫房市緩慢 不少經紀拒絕掛牌

-

- 6月1日追劇日歷,8部電視劇更新,趙麗穎《在人間》今日收官

- 正妹高中畢業舞會衣著太開放 遭校長告誡

- 妹子身上永遠臭魚味 洗澡洗不掉 吃飯就臭

- 溫哥華機場數十個航班延誤或取消

- 畢業即失業 加國20年來最慘就業季

- 溫哥華牙醫診所 提供全面牙科服務

-

- 突發!川普宣布鋼鐵關稅提高至50%

- 美國比中國可靠 中國防長成縮頭烏龜

- 加國公布這一數據超預期 加元走強

- BC備受爭議的快速基建法案獲通過

- 一刀斃命!白宮禁令,C919面臨"無心可用"危機

- 快訊:盧比奧宣布新簽證限制 劍指這些外國人

-

- 溫哥華資深貸款專家 解決貸款需求

- 被成都街拍驚艷了 滿大街都是"短裙+中筒襪"

- 陳芋汐與新搭檔奪冠 全紅嬋現狀令人唏噓

- 查航班狀態 這短缺導致航班延誤增加

- 肖戰的"命不該絕"在全網火了,梁家輝的評價,終於有人信了!

- 人口爆炸下 BC省必須刺激住房建設

-