特斯拉自动驾驶不安全? 粉丝不服

有不少人认为特斯拉汽车拥有着全世界最顶尖的无人驾驶技术,但也有人不同意这个观点。

丹·奥多德(Dan O`Dowd)是一位软件行业的创业者,同时也是着名的马斯克黑。

丹创立了一个叫作黎明计划(The Dawn Project)的项目,旨在公开那些在关键的安全系统中并不安全的软件。

而特斯拉,就是这个计划的首要目标。

根据黎明计划在网上发布的文章指出,特斯拉在自动驾驶方面存在着巨大的漏洞,大约每8分钟,全自动驾驶就会发生一次严重驾驶失误,包括:

在可以避免的情况下与物体发生碰撞;

不遵守交通标志或者信号;

不服从安全人员或者安全车辆;

做出危险动作,迫使他人采取规避行动。

平均而言,特斯拉每在城市内自动驾驶36分钟,就会出现软件方面的故障,很可能会造成严重的事故。

为此他们还特意进行了安全实验。

他们在加州(专题)一条车道上模拟了一个假人小孩儿横穿马路。测试驾驶员将特斯拉的速度提高到60公里/小时后,在靠近人体模型100米时松开双手,切换成自动驾驶模式。

结果显示,当汽车接近人体模型后,汽车会进行一定程度的减速,但并不会完全停下来,而是会以不同的速度撞向人体模型。

在视频发出之后,马斯克的粉丝根本不承认视频的真实性。

他们表示实验没有接受第三方公正,而且视频也没有拍到驾驶员全身,不知道是不是在偷偷踩油门。

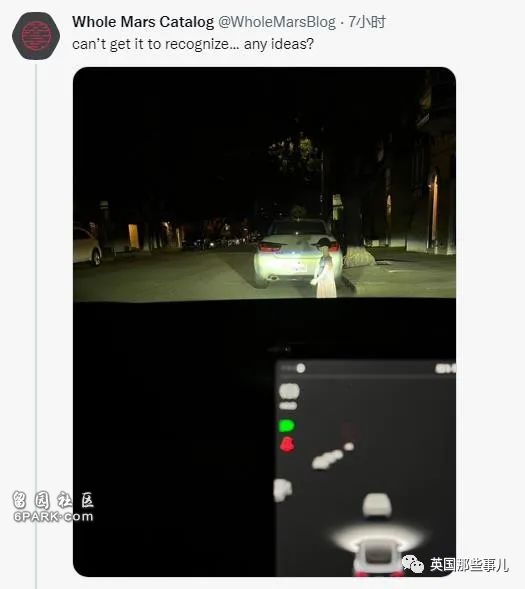

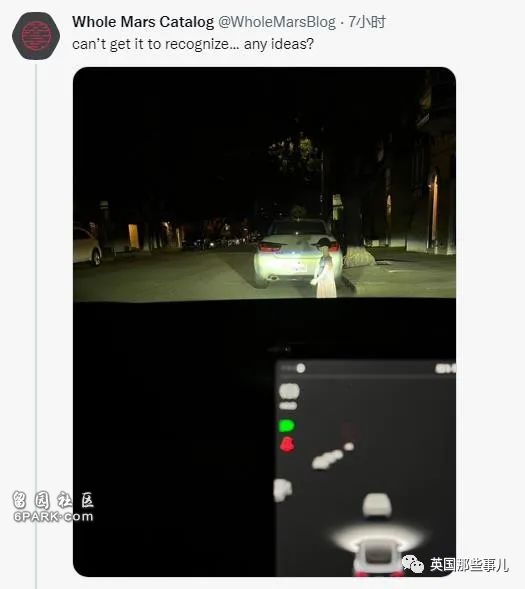

一个在推特上很有名的,特斯拉的狂热粉丝Whole Mars Catalog则表示,这实验一点都不严谨,因为假人没鼻子没眼睛,无法被特斯拉所识别。

觉得新闻不错,请点个赞吧

觉得新闻不错,请点个赞吧

还没人说话啊,我想来说几句

还没人说话啊,我想来说几句

丹·奥多德(Dan O`Dowd)是一位软件行业的创业者,同时也是着名的马斯克黑。

丹创立了一个叫作黎明计划(The Dawn Project)的项目,旨在公开那些在关键的安全系统中并不安全的软件。

而特斯拉,就是这个计划的首要目标。

根据黎明计划在网上发布的文章指出,特斯拉在自动驾驶方面存在着巨大的漏洞,大约每8分钟,全自动驾驶就会发生一次严重驾驶失误,包括:

在可以避免的情况下与物体发生碰撞;

不遵守交通标志或者信号;

不服从安全人员或者安全车辆;

做出危险动作,迫使他人采取规避行动。

平均而言,特斯拉每在城市内自动驾驶36分钟,就会出现软件方面的故障,很可能会造成严重的事故。

为此他们还特意进行了安全实验。

他们在加州(专题)一条车道上模拟了一个假人小孩儿横穿马路。测试驾驶员将特斯拉的速度提高到60公里/小时后,在靠近人体模型100米时松开双手,切换成自动驾驶模式。

结果显示,当汽车接近人体模型后,汽车会进行一定程度的减速,但并不会完全停下来,而是会以不同的速度撞向人体模型。

在视频发出之后,马斯克的粉丝根本不承认视频的真实性。

他们表示实验没有接受第三方公正,而且视频也没有拍到驾驶员全身,不知道是不是在偷偷踩油门。

一个在推特上很有名的,特斯拉的狂热粉丝Whole Mars Catalog则表示,这实验一点都不严谨,因为假人没鼻子没眼睛,无法被特斯拉所识别。

| 分享: |

| 注: | 在此页中阅读全文 |